AIGC产品已日益成为艺术和设计不可或缺的辅助创作工具。它们为设计师提供灵感、探索视觉风格。然而,AIGC面临着透明度和可解释性的挑战,这些挑战影响了用户体验,包括高学习成本、有限的有效性和信任问题。AIGC生成过程的“黑箱”性质使得普通用户(不熟悉人工智能技术)很难理解人工智能性能不佳的具体原因,阻碍了有效的调整和利用。

此外,许多因素导致不同的AIGC结果,对相同的输入产生不同的响应。由于生成结果中固有的不确定性和错误率,以及公众舆论中对人工智能道德的普遍怀疑,用户经常难以理解和信任人工智能。

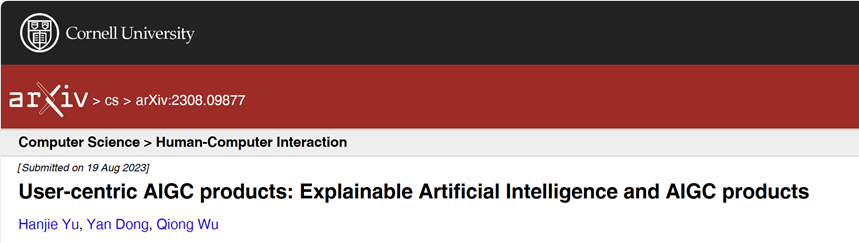

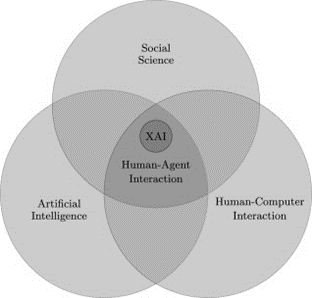

可解释人工智能(XAI)的既定目标是创建一套新的或改进的机器学习技术,以产生可解释的模型,使最终用户能够理解、适当地信任和有效地管理新一代人工智能系统。

通过将XAI集成到AIGC产品中,帮助用户理解一些算法决策过程和原理,以克服挑战,改善用户体验。XAI作为增强AIGC产品用户体验的解决方案应运而生。

论文链接:

https://arxiv.org/abs/2308.09877

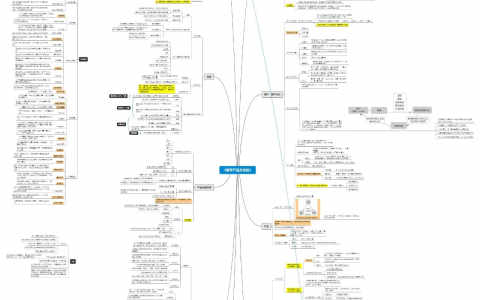

精读笔记

一、研究现状

1.1 AIGC的产出(Output)和用户想法之间的不协调

使用AIGC产品涉及不确定性和复杂性,使得反馈难以解释。由于照明、噪音或文本输入变化等因素,人工智能系统可能会产生不同的响应,导致用户难以理解这些差异并传递过去的体验。人们在观察AI模型行为后,容易产生常见的认知偏差(如锚定偏差)。这些偏差会加剧用户在再次操作时的挫折感。

这种不确定性也违背了传统人机交互中的“系统状态的可见性”、“一致性和标准”等原则。通过为AIGC生成过程提供解释,例如局部和对比解释,我们旨在缓解这种冲突,并帮助用户形成系统的想法。

1.2 XAI和用户体验

大多数XAI用户体验关注于开发人员和管理人员使用的模型,通常使用以算法为中心的方法,普通用户很少参与,无法帮助普通用户理解AI产品。为了在普通用户中推广AIGC产品,XAI必须采取以人为中心的方法。

米勒从社会学的角度确定了人性化解释的特征。

(1)解释contrastive——它们是针对特定的反事实案件而寻求的。

(2)解释是被选择的(以有偏见的方式)——人们很少期望一个事件实际完整的原因组成的解释。

(3)概率可能并不重要——虽然可能性在解释中很重要,但在解释中提及概率或统计关系不如提及原因有效。

(4)解释是社会性的——它们是知识的转移,是信念的呈现。

而Amershi等人提出了人工智能系统的18条可用性准则。

然而,这些工作大多缺乏对产品和使用改进的可操作的指导。目前,还没有关于产品和使用改进的具体建议,例如哪些XAI技术可能会集成到产品的哪个阶段。

二、将XAI技术融入AIGC产品用户体验

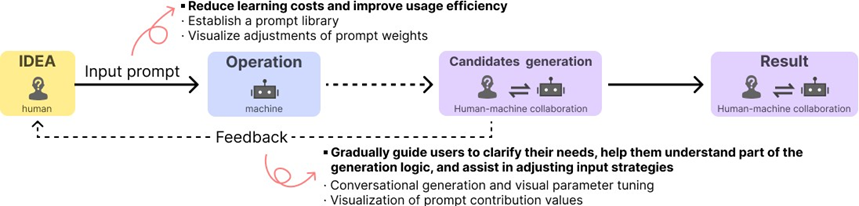

AIGC产品的工作流程由三个主要部分组成,如图2所示。传统的AIGC工作流程是一个单向的迭代过程,涉及用户输入提示和机器生成的结果。然而,这个过程缺乏输入和输出之间的清晰映射,以及来自机器生成的反馈。本文建议将XAI技术集成到AIGC工作流中,以增强输入和反馈阶段的用户体验。

2.1优化输入阶段的用户体验:提供关键词库和提示结构

对于新手用户来说,由于三个因素,输入提示可能具有挑战性:

(1)指令不明确:AIGC工具可能缺乏明确的指导,阻碍用户提供有效的输入提示。

(2)生成的内容不准确:AIGC工具可能会曲解输入提示,导致内容与用户期望不符。

(3)试错法:用户经常多次调整输入提示,以达到满意的效果。

这些问题源于新手用户无法将输入单词映射到输出结果。在传统产品中,用户利用现有知识预测结果,而在AIGC,机器取代了生产阶段,使得用户更难预测和控制调整。提示库和加权输入提示可以帮助缓解这些问题。

2.2调整反馈阶段的优化

在传统的设计方法中,设计师面临的主要挑战是通过反复概念化和迭代来理解用户真正想要的东西,然后提出创造性的解决方案,从而解决定义不清的问题。

在现有的AIGC产品中,用户被期望清楚地定义期望,并把它们翻译成机器可以理解的描述。然而,大多数用户甚至很难确定他们的需求。XAI技术可以帮助人工智能指导用户通过对话澄清他们的要求,用机器可以理解的语言表达期望。

对话生成是一种很有前途的方法,它符合人类的思维模式,并随着每次对话调整图像的各个部分,逐渐使结果符合用户要求。

三、结论

AIGC是人工智能发展最快的领域之一。然而,它目前是在以技术为中心的现实中运行的,要取得重大进展,需要专注于增强用户体验。本文中提到的用于输入和调整阶段的XAI方法旨在为用户体验改进提供可行的方向。这些见解为研究人员和实践者应用XAI和增强AIGC用户体验提供了有价值的指导。

参考文献:

[1] Tim Miller. 2019. Explanation in artificial intelligence: Insights from the social sciences. Artificial intelligence 267 (2019), 1–38.

[2] Donghee Shin. 2021. The effects of explainability and causability on perception, trust, and acceptance: Implications for explainable AI. International Journal of Human-Computer Studies 146 (2021), 102551.

饶菡 | 技术编辑

袁毅、赵星 | 审校

© THE END

转载请联系本公众号获得授权

关于元宇宙学社

在华东师范大学元宇宙与数智人实验室、经管学部信息管理系和专业学位教育中心MBA联合会的支持下,由MBA学生自主发起的俱乐部组织。

招募对象:华东师范大学全体在校生及毕业校友、元宇宙领域从业者及兴趣爱好者。

诚邀!快来扫码加入吧!

扫码识别二维码关注

本文来自https://mp.weixin.qq.com/s/5pWDBbQwtUMUof_F2bnPsw,本文观点不代表 PmTemple 立场,转载请联系原作者。原文链接:元宇宙学报

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫